NVIDIA H100

Tensor コア GPU

あらゆるデータ センターにかつてな

い性能、拡張性、セキュリティを提供

あらゆるデータ センターにかつてな

い性能、拡張性、セキュリティを提供

| 規格 | H100 SXM | H100 PCIe | H100 NVL² |

|---|---|---|---|

| FP64 | 34 teraFLOPS | 26 teraFLOPS | 68 teraFLOPs |

| FP64 Tensor コア | 67 teraFLOPS | 51 teraFLOPS | 134 teraFLOPs |

| FP32 | 67 teraFLOPS | 51 teraFLOPS | 134 teraFLOPs |

| TF32 Tensor コア | 989 teraFLOPS² | 756 teraFLOPS² | 1,979 teraFLOPs² |

| BFLOAT16 Tensor コア | 1,979 teraFLOPS² | 1,513 teraFLOPS² | 3,958 teraFLOPs² |

| FP16 Tensor コア | 1,979 teraFLOPS² | 1,513 teraFLOPS² | 3,958 teraFLOPs² |

| FP8 Tensor コア | 3,958 teraFLOPS² | 3,026 teraFLOPS² | 7,916 teraFLOPs² |

| INT8 Tensor コア | 3,958 TOPS² | 3,026 TOPS² | 7,916 TOPS² |

| GPU メモ リ | 80GB | 80GB | 188GB |

| GPU メモリ 帯域幅 | 3.35TB/秒 | 2TB/秒 | 7.8TB/秒³ |

| デコーダー | 7 NVDEC 7 JPEG | 7 NVDEC 7 JPEG | 14 NVDEC 14 JPEG |

| 最大熱設計電力 (TDP) | 最大 700W (構成可能) | 300–350W (構成可能) | 2x 350-400W (構成可能) |

| マルチインスタンス GPU | 最大 7 個の MIG @ 10GB | 最大 7 個の MIG @ 10GB | 各 12GB の最大 14 のMIG |

| フォーム ファクター | SXM | PCIe デュアルスロット空冷 | 2x PCIe dual-slot air-cooled |

| 相互接続 | NVLink: 900GB/秒 PCIe Gen5: 128GB/秒 | NVLINK: 600GB/秒 PCIe Gen5: 128GB/秒 | NVLINK: 600GB/秒 PCIe Gen5: 128GB/秒 |

| サーバー オプション |

4 または 16 GPU 搭載の NVIDIA HGX™ H100 パー トナーおよび NVIDIA- Certified Systems™ 8 GPU 搭載の NVIDIA DGX™ H100 |

1~8 GPU 搭載の パートナーおよび NVIDIA Certified Systems™ |

2-4 組のパートナー および NVIDIA Certified Systems |

| NVIDIA AI Enterprise | アドオン | 含む | 含む |

かつてない VDI ユーザー エク

スペリエンスを実現

| GPU メモリ | 4x 16GB GDDR6、誤り訂正符号 (ECC) 機能付き |

| GPU メモリ帯域幅 | 4x 200 GB/秒 |

| 最大消費電力 | 250W |

| 相互接続 | PCI Express Gen 4 x16 |

| フォーム ファクター | フル ハイト フル レングス (FHFL) デュアル スロット |

| サーマル | パッシブ |

| vGPU ソフトウェア サポート |

NVIDIA 仮想 PC (vPC)、NVIDIA 仮想アプリケーション (vApp)、 NVIDIA RTX ワークステーション (vWS)、NVIDIA 仮想コンピュート サーバ- (vCS) |

| サポートされている vGPU プロファイル |

仮想 GPU ライセンス ガイド および NVIDIA AI Enterprise ライセンス ガイドをご覧ください。 |

| NVENC | NVDEC | 4x | 8x (AV1 デコードを含む) |

| ハードウェアの信頼の基点に よるセキュア/測定ブート | はい (任意) |

| NEBS Ready | レベル 3 |

| 電源コネクタ | 8 ピン CPU |

主流のエンタープライズ サーバ

ーのためにグラフィックスとビ

デオを AI で高速化

| FP32 | 31.2 teraFLOPS |

| TF32 Tensor コア | 62.5 teraFLOPS | 125 teraFLOPS* |

| BFLOAT16 Tensor コア | 125 teraFLOPS | 250 teraFLOPS* |

| FP16 Tensor コア | 125 teraFLOPS | 250 teraFLOPS* |

| INT8 Tensor コア | 250 TOPS | 500 TOPS* |

| INT4 Tensor コア | 500 TOPS | 1,000 TOPS* |

| RT コア | 72 RT コア |

| エンコード/デコード | 1 エンコーダー 2 デコーダー (+AV1 デコード) |

| GPU メモリ | 24GB GDDR6 |

| GPU メモリ帯域幅 | 600GB/s |

| インターコネクト | PCIe Gen4 64GB/s |

| フォーム ファクター | シングルスロット、フルハイト、フルレングス (FHFL) |

| 最大熱設計電力 (TDP) | 150W |

| vGPU ソフトウェア サポート |

NVIDIA 仮想 PC、NVIDIA 仮想アプリケーション、NVIDIA RTX 仮想ワークステーション、NVIDIA 仮想コンピューティング サーバー, NVIDIA AI Enterprise |

NVIDIA AI をあらゆるサーバー

にもたらすエントリ レベル GPU

| Peak FP32 | 4.5 TF |

| TF32 Tensor コア | 9 TF | 18 TF¹ |

| BFLOAT16 Tensor コア | 18 TF | 36 TF¹ |

| Peak FP16 Tensor コア | 18 TF | 36 TF¹ |

| Peak INT8 Tensor コア | 36 TOPS | 72 TOPS¹ |

| Peak INT4 Tensor コア | 72 TOPS | 144 TOPS¹ |

| RT コア | 10 |

| Media engines | 1 video encoder 2 video decoders (includes AV1 decode) |

| GPU メモ リ | 16GB GDDR6 |

| GPU メモリ帯域幅 | 200GB/s |

| 相互接続 | PCIe Gen4 x8 |

| フォームファクター | 1-slot, low-profile PCIe |

| 最大熱設計電力 (TDP) | 40–60W (configurable) |

| Virtual GPU (vGPU) software support² |

NVIDIA Virtual PC (vPC), NVIDIA Virtual Applications (vApps), NVIDIA RTX Virtual Workstation (vWS), NVIDIA AI Enterprise, NVIDIA Virtual Compute Server (vCS) |

データ センターの AI とグラフ

ィックスで発揮される比類なき

パフォーマンス

| GPU アーキテクチャ | NVIDIA Ada Lovelace アーキテクチャ |

|---|---|

| GPU メモリ | 48 GB GDDR6 (ECC 搭載) |

| メモリ帯域幅 | 毎秒 864GB |

| 相互接続インターフェイス | PCIe Gen4 x16: 毎秒 64GB 双方向 |

| NVIDIA Ada Lovelace アーキテクチャベースの CUDA® コア | 18,176 |

| NVIDIA 第 3 世代 RT コア | 142 |

| NVIDIA 第 4 世代 Tensor コア | 568 |

| RT コア パフォーマンス TFLOPS | 212 |

| FP32 TFLOPS | 91.6 |

| TF32 Tensor コア TFLOPS | 183 I 366* |

| BFLOAT16 Tensor コア TFLOPS | 362.05 I 733* |

| FP16 Tensor コア | 362.05 I 733* |

| FP8 Tensor コア | 733 I 1,466* |

| ピーク INT8 Tensor TOPS ピーク INT4 Tensor TOPS | 733 I 1,466* 733 I 1,466* |

| フォーム ファクター | 4.4” (H) x 10.5” (L)、デュアル スロット |

| Display Ports | 4x DisplayPort 1.4a |

| 最大消費電力 | 350W |

| 電源コネクタ | 16 ピン |

ビデオ、AI、グラフィックスを効

率的に実現する、飛躍的進化を遂

げたユニバーサル アクセラレータ

| FP32 | 30.3 teraFLOPs |

| TF32 Tensor コア | 120 teraFLOPS* |

| FP16 Tensor コア | 242 teraFLOPS* |

| BFLOAT16 Tensor コア | 242 teraFLOPS* |

| FP8 Tensor コア | 485 teraFLOPs* |

| INT8 Tensor コア | 485 TOPs* |

| GPU メモリ | 24GB |

| GPU メモリ帯域幅 | 300GB/s |

| NVENC | NVDEC | JPEG デコーダー | 2 | 4 | 4 |

| 最大熱設計電力 (TDP) | 72W |

| フォーム ファクター | 1- スロット ロープロファイル、 PCIe |

| インターコネクト | PCIe Gen4 x16 64GB/s |

| サーバー オプション | 1-8 基の GPUが搭載できるパートナーおよび NVIDIA-Certified Systems 対応システム |

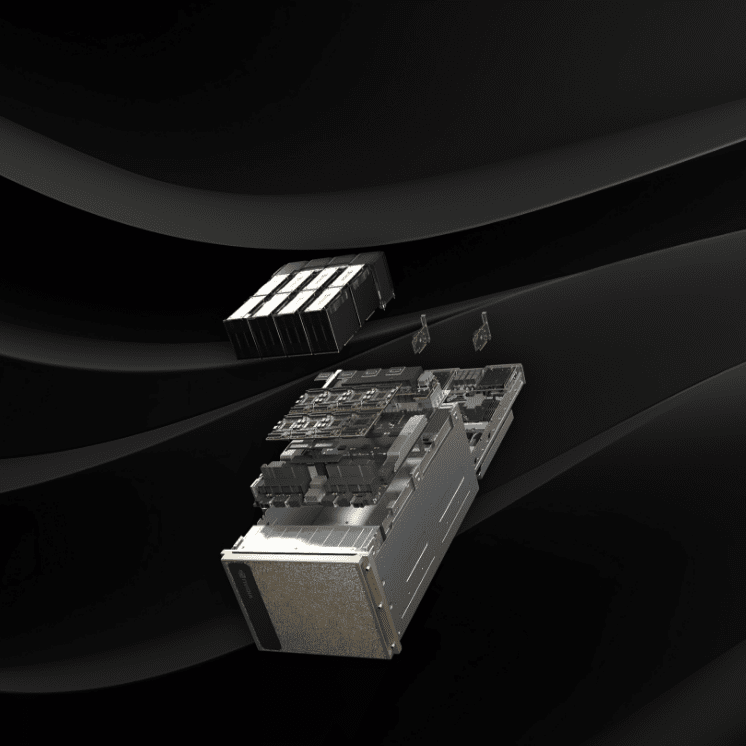

World-proven enterprise AI

| GPUs | 8x NVIDIA H100 Tensor コア GPU |

|---|---|

| GPU メモリ | 合計 640GB |

| パフォーマンス | 32 petaFLOPS FP8 |

| NVIDIA® NVSwitch™ | 4x |

| システム消費電力 | 最大 10.2kW |

| CPU |

デュアル Intel® Xeon® P latinum 8480C プロセッサ(合計 112 コア)、2.00GHz (ベース)、3.80GHz(最大ブースト時) |

| システム メモリ | 2TB |

| ネットワーキング |

4 個の OS FP ポートで 8 基のシングル ポート C onnectX-7 VPI > 400Gb/s Inf iniB and/Ethernet 2 基のデュアルポート QSFP112 NVIDIA ConnectX-7 VP I > 400Gb/s Inf iniB and / Ethernet |

| 管理ネットワーク |

10Gb/s オンボード NIC(RJ 45 付き) 100 Gb/s Ethernet NIC ホスト ベースボード管理コントローラー(B M C)(RJ 45 付き) |

| ストレージ | OS : 1.92TB NVM e M .2 2枚 |

| 内部ストレージ: | 3.84TB NVM e U.2 8枚 |

| ソフトウェア |

NVIDIA AI Enterprise – AIソフトウェア NVIDIA Base Command – オーケストレーション、スケジューリング、 クラスタ管理 DGX OS / Ubuntu / Red Hat Enterprise Linux / Rocky – Operating System |

| サポート | 3 年間のビジネス標準ハードウェアおよび ソフトウェア サポートが付属 |

| システム重量 | 130.45kg |

| 梱包重量 | 170.45kg |

| システム寸法 |

高さ:356mm 幅:482.2mm 長さ:897.1mm |

| 動作温度範囲 | 5–30°C (41–86°F) |